서버 / HPC에서 일으킨 구조 변화의 재현을 노리는 Intel

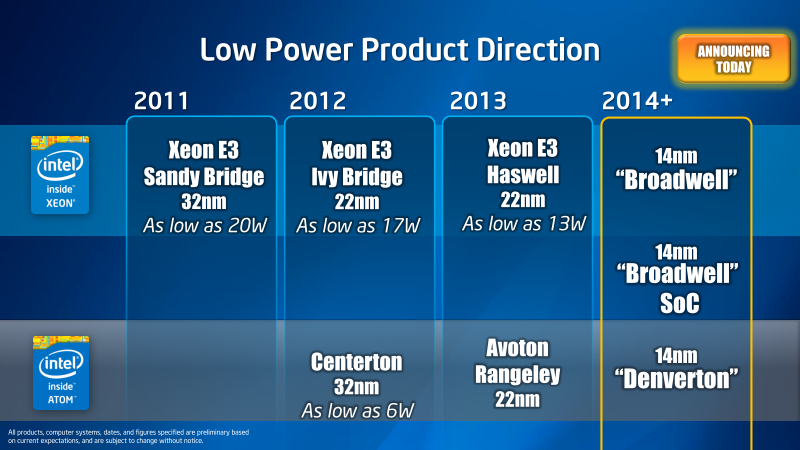

Intel은 저전력 CPU 코어 기반 서버 제품에 주력하고 있다. 이미 회사는 32nm 공정의 "Atom S1200 '시리즈 (Centerton)를 도입하고 있지만, 후계가 되는 22nm 공정 "Avoton ","Rangeley'를 올해 (2013 년), 14nm의 "Denverton"그 후 투입 한다. Centerton이 기존 모바일 Atom의 다이 (반도체 본체)를 서버용으로 한 "임시 변통 제품"이었던 비해 Avoton 이후의 제품은 서버 시장을 위해 설계된 제품이다.

Intel은 Atom 기반의 서버 제품 외에도, Haswell (하스웰) 아키텍처 계에서 14nm 프로세스 "Broadwell"의 SoC (System on a Chip) 버전도 서버에 투입한다. 이러한 새로운 브랜드의 서버 CPU의 투입으로 Intel이 궁극적으로 목표하고 있는 것은 "Re-Architecting The Datacenter"즉, 데이터 센터의 재 구축이다. Intel은 일찍이 서버 시장에서 한번 이것을 달성했다. 그 재현을 행하려 하고 있다.

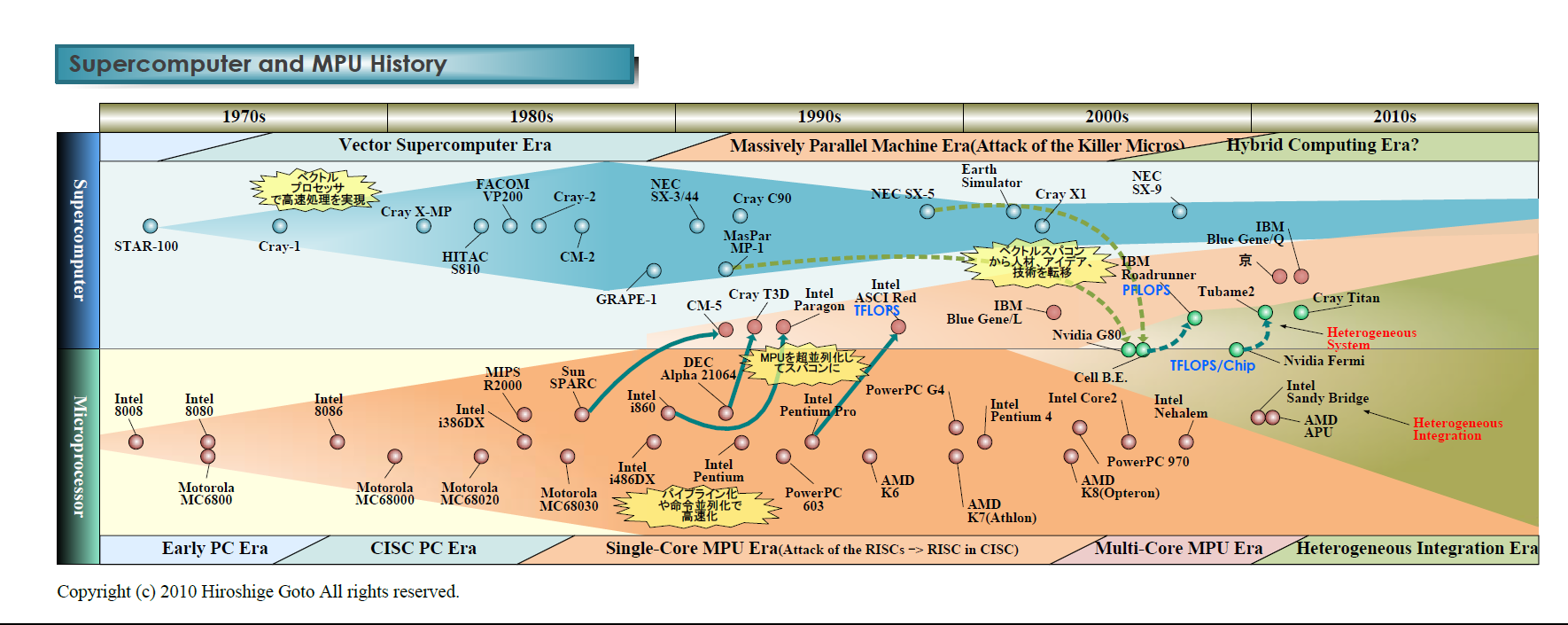

Intel이 과거 재구성 예로 든 것은 슈퍼 컴퓨터다. 아래 보는 바와 같이, Intel은 1990 년대 중반 이후 슈퍼 컴퓨터에 지각 변동을 가져왔다. 이 슬라이드는 3 가지 중요한 포인트를 나타내고 있다.

1990 년대에 일어난 슈퍼 컴퓨터의 변화

1990 년대의 슈퍼 컴퓨터는 소위 "Attack of the Killer Micros (MPU의 공세)"시대, 벡터 컴퓨터에서 슈퍼 스칼라 프로세서의 대규모 병렬 구성의 시스템으로 전환했다. 그것으로 슈퍼 컴퓨터의 주역이었던 벡터 컴퓨터는 구조 변화의 결과인, 초 병렬 마이크로 프로세서에 주류 자리를 빼앗긴다. Intel은 그런 슈퍼 컴퓨터 변혁의 파도에 큰 역할을 했다.

그러나 Attack of the Killer Micros이 시작된 초기에는 슈퍼 컴퓨터는 RISC 프로세서를 기반으로 했다. 당시 하이 엔드 서버는 어느곳이나 각사의 RISC 프로세서를 기반으로하고 있었으며, 초병렬 슈퍼 컴퓨터도 그 연장에 있었다. Intel도 처음에는 자사의 RISC "Intel i860 ' 으로 슈퍼 컴퓨터를 개발했다.

P6에서 서버에 본격 진출한 Intel

그 흐름이 바뀐 것은, Intel이 "Pentium Pro (P6)"서버로 공세를 시작했을 때 부터다. Intel은 그뒤 CPU에 짧은 벡터인 MMX / SSE 계 명령 확장을 내장한 x86 기반 초병렬 슈퍼 컴퓨터 "ASCI Red"에서 TFLOPS를 달성한다. 그리고 최근 보이는 것과 같이, x86 계 프로세서가 슈퍼 컴퓨터의 주류가 될 흐름을 만들어 냈다. 이것은 서버 시장에서 x86이 RISC를 몰아내는 것과 동기화 되어 있었다. Intel은 x86 볼륨에 의한 규모의 이점으로 서버 시장을 바꿔 버렸다.

슈퍼 컴퓨터와 MPU의 역사

슈퍼 컴퓨터에서 Intel은 이러한 두 가지 구조 변화, 벡터 컴퓨터에서 스칼라의 초병렬 기계의 변화와 RISC에서 x86의 변화 두 가지를 실현했다. Intel의 x86은 슈퍼 컴퓨터뿐만 아니라 하이 엔드 서버 시장을 차지하게 되었다. 그러나 대상 슬라이드에 "15 년간 FLOPS 당 비용의 저감이 100 배"라는 숫자가 Intel 접근의 한계를 보여주고 있다.

무어의 법칙대로 라면 15년간 트랜지스터 비용이 180 분의 1의 것. 게다가 칩의 주파수도 상승하기 때문에, FLOPS 당 비용 절감은 더 나아가야 좋은 것이다. 그런데 그렇게 되지 않는다. 이유는 여러 가지 있지만 그 중 하나는 슈퍼 스칼라 프로세서는 단일 스레드 성능 향상은 무어의 법칙으로 증가되는 트랜지스터의 제곱근 분 밖에 기대할 수 없다 (= 폴락의 법칙, / 암달의 법칙 ). 또한 CMOS 스케일링의 벽에 의해 주파수의 향상이 둔화되고 있는 것도 있다.

그리고 최근에는 슈퍼 컴퓨터 톱 500의 상위는 GPU 기반의 이기종 구성 "BlueGene / Q" 중소 매니 코어 구성으로 침투되고 있다. Intel은 "Xeon Phi"(Knights Corner)에 의한 이기종 구성에서 슈퍼 컴퓨터 최고 자리는 확보했지만, 전력 효율에 물음표를 붙여 버렸다.

즉, 위의 슬라이드는 Intel이 Pentium Pro 이후 이룩한 서버 및 HPC (High Performance Computing)의 구조 변화를 보여 주지만, 동시에 그 흐름의 한계도 시사하고 있다. Intel은 새로운 구조 변화에 직면하고 있으며, P6부터 접근과는 다른 대응이 필요하게 되었다.

서버 시장의 양 · 다양성 · 전력 수요의 변화

무엇이 지금 서버에 일어나고 있는 것인가. 서버에는 큰 변화가 3개 발생하고 있다. 하나는 양적인 확대로 클라우드 컴퓨팅의 보급과 함께 서버 시장이 급속히 확대하고 있다. 다른 하나는 질적인 변화로 클라우드 및 빅 데이터, 네트워크 및 스토리지 리 아키텍처는 데이터 센터 워크로드가 크게 변화하고 다양화 하고 있다. 세 번째는 서버의 규모가 커짐에 따라 전력 당 성능 효율이 매우 중요해진 것이다.

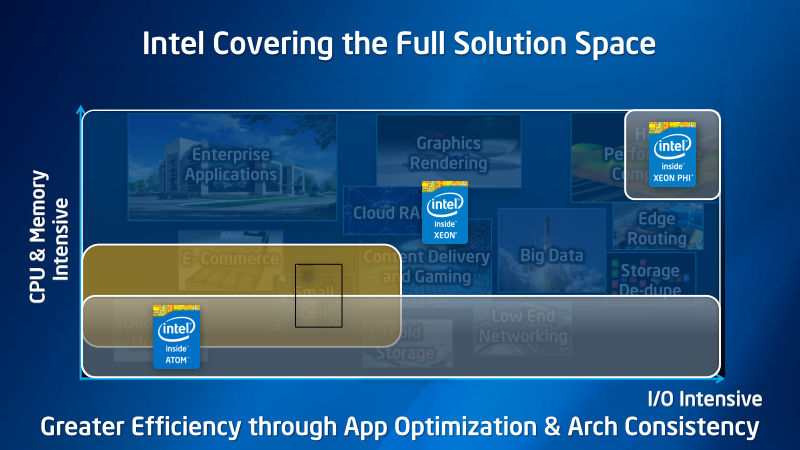

이러한 변화에 따라 서버도 "원 사이즈 피츠 올 (one size fits all)"모델이 유효하지 않게 되었다. 단일 아키텍처로 시장을 모두 커버 할 수 없는 상황이 이제 가고 있다. 따라서 Intel도 서버에서 여러 솔루션을 필요로 하게 되었다.

데이터 센터의 용도에 따라 요구되는 성능이 다름

Intel은 여러 솔루션을 서버 전용으로 제공

Intel 해답의 하나는 대 GPU 서버로 개발한 Xeon Phi를 보면, 소형 벡터 강화 코어의 컴퓨테이션 집중 워크로드에 대한 대응이다. Xeon Phi는 주로 HPC 용이지만, Intel은 다른 접근을 필요로 하고 있다. 그 대표가 서버의 새로운 구조 변화의 물결이 되는 "마이크로 서버"(Microserver)의 시작, 저전력 서버의 흐름이다. 스몰 코어 서버 등으로 불리는 경우도 있다. 빅 데이터 등 새로운 워크로드에 이상적인 서버 접근이다.

마이크로 서버는 스레드 당 성능은 낮지만 전력 효율이 높고, 스레드 병렬성이 높고, I / O 성능이 뛰어난 새로운 서버 범주이다. 마이크로 서버의 동기 중 하나는 성능 효율과 절대 성능 트레이드 오프에 있다. 스몰 코어는 절대 성능이 낮지만 성능 효율이 뛰어나다. 따라서 전력 당 성능을 중시하는 서버 분야에서는 저전력 프로세서 아키텍처의 서버를 요구하는 추세가 강해지고 있다. (이런 이유도 포함되어서 인텔 서버 점유율이 95%나 되는 것 입니다. AMD는 거의 없는 수준이구요. AMD가 전력대비 성능이 떨어지죠.)

특히 단일 스레드 성능이 중요하지 않고 캐시 적중률이 낮고, 메모리 및 I / O 액세스가 다발하는 워크로드는 스몰 코어로 향하고 있다. 캐시 미스시 및 I / O 대기 전력 손실은 스몰 코어 쪽이 작기 때문이다. 이러한 분석은 새로운 것이 아니라, Oracle에 흡수 된 Sun Microsystems (Sun)이 스몰 코어 "Niagara"(나이아가라)를 개발했을 때부터 지적하고 있다. Sun은 Niagara을 발표했을 때의 슬라이드는 명확하게 개념을 표시하고있다.

스몰 코어의 가능성을 지적했던 Sun Microsystems 슬라이드

Sun은 이때 스레드 병렬성 (TLP)이 매우 높은 응용 프로그램에서 작업 세트가 크고 데이터 국소성이 낮아 캐시 미스 비율이 높고, 스레드 간의 데이터 공유도 많은 경우 기존의 라지코아에서는 성능이 발휘 할 수 없다고 했다.

ARMv8 서버의 분류가 2014 년부터 시작

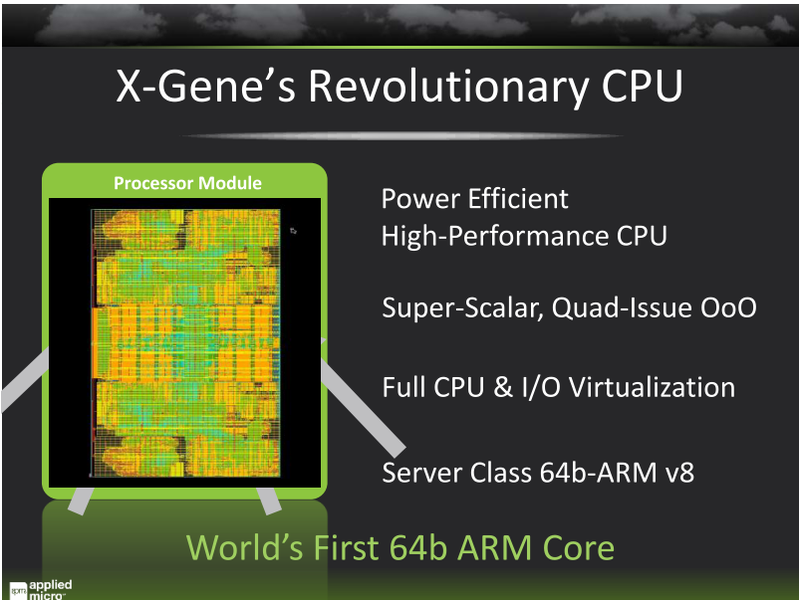

Niagara부터 시작된 스몰 코어 서버의 흐름은 CPU 집중이 아닌 서버 분야가 확산되고 있는 것으로 주목을 받고있다. 그리고 마이크로 서버로 카테고리가 성립되기 시작하는 기색이 보였던 것으로, 거기에 ARM 커뮤니티가 참가하기 시작했다. 성능 / 전력이 뛰어난 ARM 코어 마이크로 서버를 실현하고자 하는 흐름이.

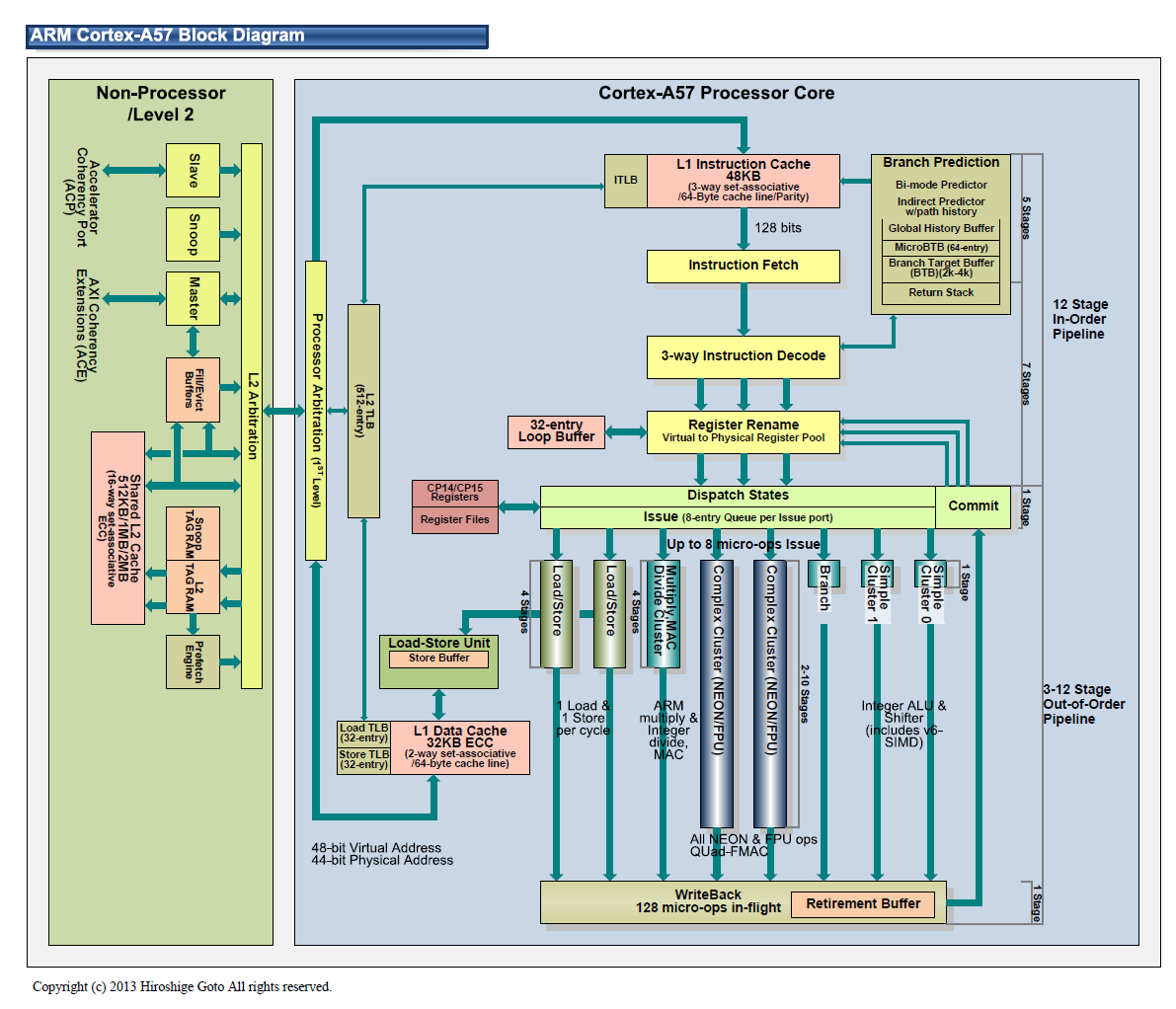

ARM은 이를 위해 64bit 아키텍처의 새로운 명령 세트 "ARMv8"을 앞당겨 발표했다. 그것을 타고, Applied Micro 및 Calxeda, Cavium 같은 업체가 ARM 서버 CPU의 개발을 진행시켜 왔다. 모바일 시장에서 ARM 코어의 주력 업체도 참가의 기미를 보이고 있다. 또한 x86 의 한쪽 이었던 AMD도 마이크로 서버는 ARM 코어를 선택했다. "Seattle"은 8 또는 16 코어 "Cortex-A57"를 탑재한다.

마이크로 서버용으로 앞 당겨진 64bit ARM 코어 "ARMv8"

AMD는 "Seattle"에서 ARM 아키텍처

ARM Cortex-A57 블록 다이어그램

ARMv8의 마이크로 서버가 본격화 되는 것은 2014 년이다. 마이크로 서버를 메는 업체는 이 조류가 전체 서버의 구조 변화에 이어지는 것으로 예상하고 있다.

따라서 Intel도 대응해야 하는 상황에 있다. Intel의 선택은 x86 기반 마이크로 서버에 긴급 조치로 모바일의 Atom을 서버 전용으로 투입했다. 그러나 Centerton 이 Intel의 본심이 아닌 것은 확실, Intel은 본격적인 서버 제품인 Avoton, Rangeley, 그리고 Denverton을 급 전개 할 필요에 있었다.

Intel의 마이크로 서버용 프로세서 로드맵

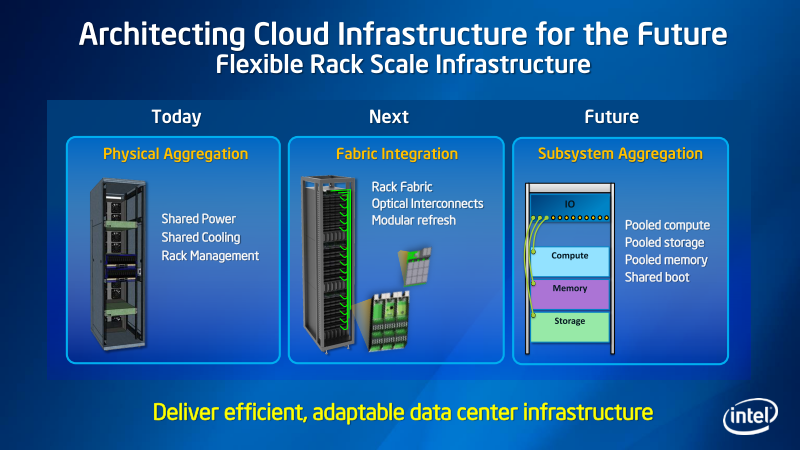

또한 Intel은 서버의 구조 변화 속에는 소프트웨어 디파인 (소프트웨어 정의) 화도 있다고 지적하고 있다. "Software Defined Network"이거나 "Software Defined Storage" 라고 Intel이 부르는 흐름이다. 이 조류도 명확하고 네트워크 및 스토리지 부분이 소프트웨어화 하고 유연한 모듈이 된다. 이 부분에서도 새로운 컴퓨팅 요소가 필요 하게 된다.

스토리지 및 네트워크 등 소프트웨어 디파인의 변화

CPU와 캐시 집중이 아닌 워크로드에 최적화

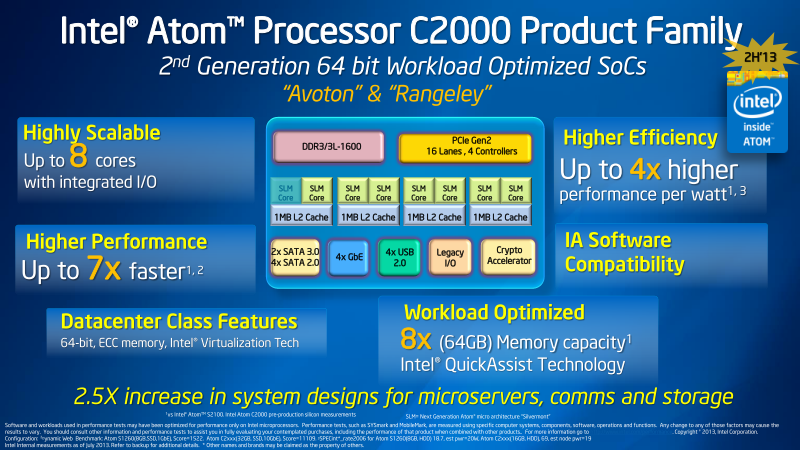

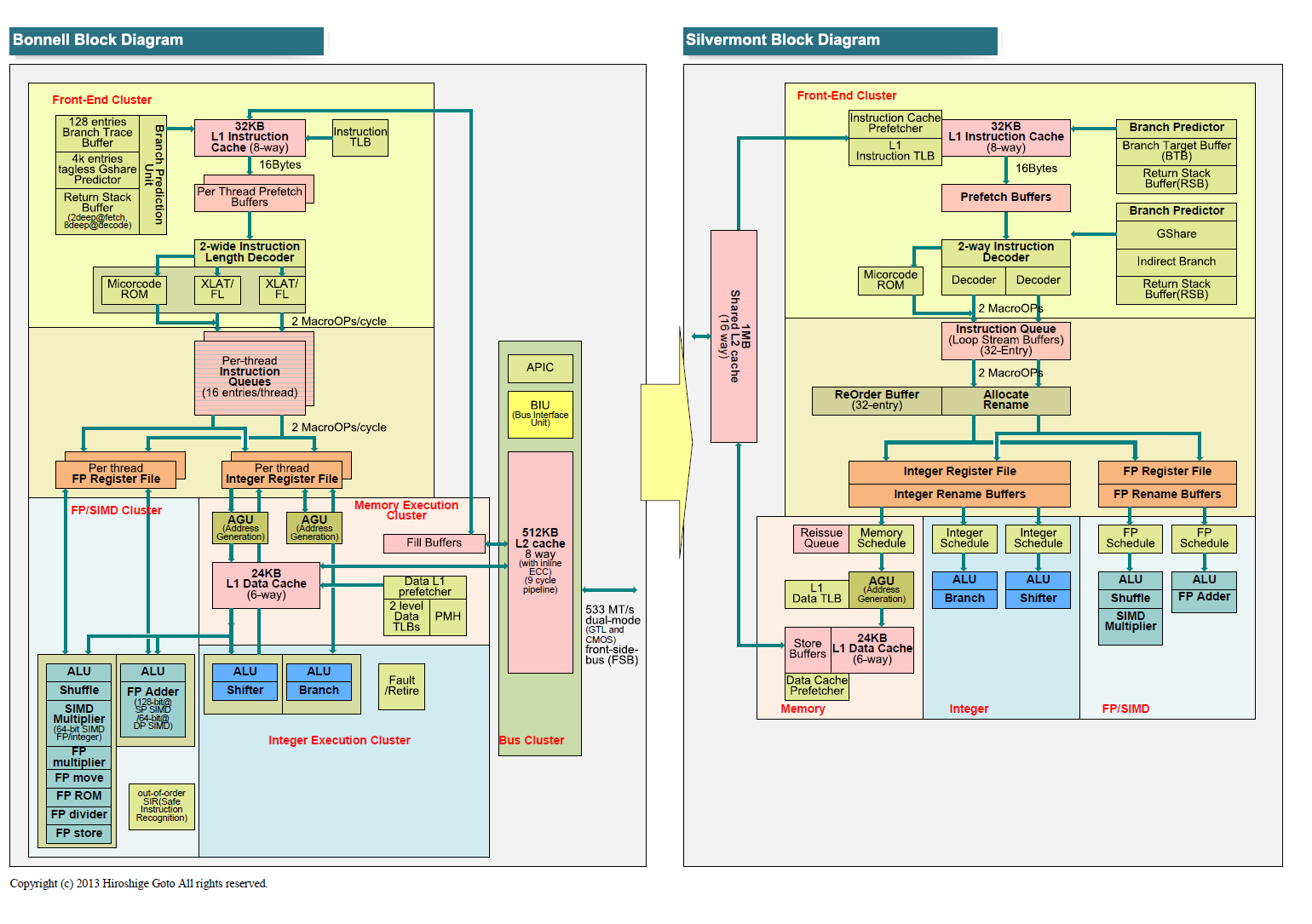

그러면 구체적으로 Intel 어떻게 대응해 나갈 것인가. Intel이 보여준 22nm 프로세스의 Avoton / Rangeley 그림이 방향성을 명확하게 보여주고 있다. Avoton은 Intel의 새로운 저전력 코어인 'Silvermont "(실버몬트 이 아키텍처 코어를 쓴 개인용 제품이 아톰 베이트레일 입니다.)를 8코어 탑재한 일반 서버 CPU로 다른 칩에 있던 각종 I / O도 원 칩에 통합한 SoC 제품이다 .

Avoton / Rangeley의 특징

8 개의 Silvermont 코어 2코어 씩 1MB의 L2 캐시를 공유한다. 이 CPU 부분에는 기존의 서버 CPU와 차이가 명확하게 보인다. 먼저 당연한 일이지만, Intel의 고성능 CPU 코어 보다 훨씬 싱글 스레드 성능이 떨어진다. 그리고 기존의 서버 CPU는 8코어도 탑재한다면, 10MB 이상의 대용량 공유 캐시를 얹고 프로세서 간의 스누핑 트래픽을 줄일 수 있었지만, 그것도 보이지 않는다.

Bonnell과 Silvermont의 블록 다이어그램 비교

(쉽게 말하면 구세대 아톰과 신형 아톰의 비교가 되겠죠.)

Intel 제 프로세서의 아키텍처 비교

즉, Avoton / Rangeley는 단일 스레드 성능이 중요하지 않고 캐시 히트별로 기대할 수 없는 워크로드에 최적화 된, 바로 마이크로 서버 분석에 따른 아키텍쳐가 되고 있다. 이 점은 기존의 대용량 캐시를 얹은 소형 코어 서버와 명확히 달리 ARM 서버와 같은 흐름이다.

하지만 Avoton / Rangeley의 특화 정도는 아직 중간의 느낌도 있다. I / O도 통합하고 있지만, I / O 방향을 대폭 강화하고 있다고도 아직 말할 수 없다. 메모리 인터페이스도 공격적으로 광대역 메모리를 채용하는 등 교류가 아니다. Intel의 신중한 모습을 보이며 Avoton / Rangeley 를 개발하고 있는 것으로 나타났다.

시장은 아직 작지만 고객은 큰

문제는 어디에 있는가 하면, 아직 시장의 모습이 분명히 보이지 않는 점에있다. 서버 SoC에 어떤 기능을 통합하는 것이 적절한지, 어디까지 액셀을 밟아야 좋은 것인지, 좀처럼 명확하지 않다. 서버 시장의 다양화 / 단편화가 심해 어디에 초점을 맞추면 좋은 것인지, 판단이 어려운 것이 현실이다.

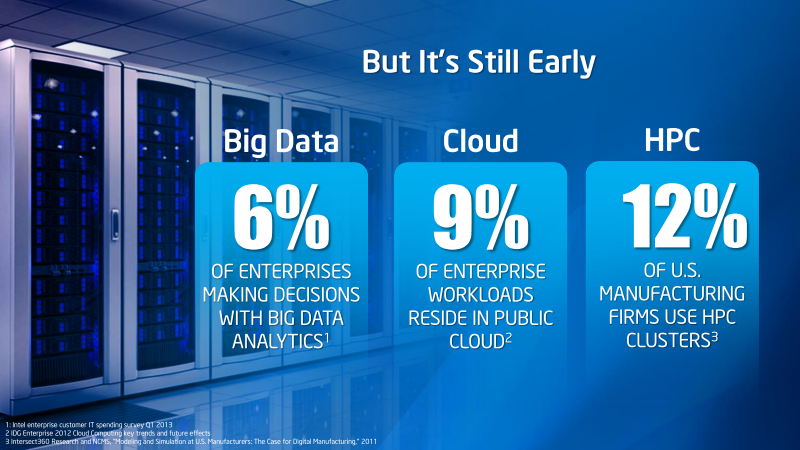

또한 서버 CPU 시장은 수량으로 PC와 모바일에 비해 훨씬 작다. 게다가 새로 나온 차세대 서버의 파도가 얼마나 볼륨을 필요로 하는지 파악하기 어렵다. 개별 시장 부문이 작고, 갑자기 액셀을 밟아 대대적으로 추진하더라도 너무 빠르면 실패로 끝날 가능성도 있다. Intel의 아래 슬라이드는 이러한 문제를 명확하게 보여주고 있다. 빅 데이터로 소란을 피우고 있어도 그 방향으로 방향타를 돌린 기업의 수는 6%에 불과 하다고 Intel은 본다.

빅 데이터에 방향타를 돌린 기업은 6 %라는 Intel의 결과

또한 이야기를 어렵게 하고 있는 것은 고객의 수와 노드 규모다. 예를 들어, 성능 / 전력이 중요한 빅 데이터 응용 프로그램은 Memcached와 같은 분산 메모리 캐시 시스템에도 사용되고 있으며, 저전력 코어 서버는 거기에서 활용이 기대되고 있다. Memcached는 비 CPU 집중 작업 부하의 대표이기 때문이다.

그러나 Memcached를 사용하는 유저는 Facebook과 같은 초 거대 서버를 안고 있는 곳만. 아래의 2011년 JEDEC의 컨퍼런스에서 Facebook의 프레젠테이션에서 Memcached 서버에서 요청이 CPU가 아닌 메모리에 있는 것이 명확하게 나타나고 있다. 그리고 Memcached 사용자는 개별 데이터 센터의 규모는 크지만, 그 사용자 수는 제한된다. 따라서 1 유저를 획득하면 엄청난 숫자가 설치된다는 상황이다. 즉, 수는 적은 큰 고객 쟁탈전이 된다.

Facebook의 Memcached 서버에서 요청

간단히 말하면, 시장 규모는 아직 작지만 놓치는 경우 빅 유력 고객을 놓칠 수도 있는 상황이다. Intel은 이 복잡한 상황을 자신의 x86 아키텍처와 첨단 공정 기술, 그리고 저전력 기술로 극복하려 하고 있다.

[분석정보] Intel, 14nm SoC 버전 Broadwell / Denverton 절전 서버 출시

'벤치리뷰·뉴스·정보 > 아키텍처·정보분석' 카테고리의 다른 글

| [분석정보] AMD가 Hot Chips에서 Richland에서 확장한 전력 제어 장치 등을 발표 (0) | 2013.08.30 |

|---|---|

| [분석정보] IBM, Oracle, 후지쯔가 최첨단 프로세서를 선보이다 (0) | 2013.08.28 |

| [분석정보] IBM이 기술의 집대성 괴물 CPU Power8 발표 (0) | 2013.08.28 |

| [분석정보] 고속화와 함께 전력 절약에도 눈 돌리는 PCI Express 3.1 (0) | 2013.08.26 |

| [분석정보] 부드러운 데이터 센터를 만드는 Intel의 Software Defined Infrastructure (0) | 2013.07.30 |

| [분석정보] 20나노 공정부터 앞으로 무어의 법칙의 의미가 없어지나? ~ 트랜지스터당 비용 상승 (0) | 2013.07.09 |

| [분석정보] 인텔 하스웰 설계를 행한 마레이시아 제조 개발 거점을 공개 (0) | 2013.07.08 |

| [분석정보] 하스웰 eDRAM에 JEDEC 차세대 DRAM으로 대항하는 AMD의 메모리 전략 (0) | 2013.07.08 |